Negli ultimi tempi, si è discusso ampiamente di ChatGPT, l’intelligenza artificiale sviluppata da OpenAI, una compagnia californiana che ha ricevuto notevoli finanziamenti da alcune BigTech. Il 14 marzo 2023 è stata presentata GPT-4, l’ultima versione del modello, capace di elaborare sia immagini che testo e generare risposte testuali.

In questo articolo, oltre a chiarire alcuni concetti spesso confusi o fraintesi, analizziamo l’utilizzo di GPT-4 nel campo dei Pagamenti Innovativi. Esploreremo gli scenari di sviluppo resi possibili dalla PSD3 e dal framework di Open Finance europeo (in procinto di essere pubblicati), nonché dal nuovo schema SEPA Payment Account Access. Valuteremo le applicazioni meritevoli di attenzione dal punto di vista strategico, presentando anche esempi pratici delle potenzialità di GPT-4 a supporto della monetica e dei sistemi di incasso e pagamento innovativi.

Le opportunità offerte da queste tecnologie per banche, aziende, fornitori di servizi di pagamento e utenti, e come queste possano influenzare gli sviluppi della tecnofinanza, sono gli “ingredienti” che, accompagnati da un’analisi dei rischi, costituiscono i temi trattati in questo articolo.

Il contributo fa parte della rubrica “La Riflessione”, a firma di Roberto Garavaglia; uno spazio dedicato da PagamentiDigitali.it per un’analisi critica e un confronto costruttivo sui fenomeni di maggiore attualità che riguardano l’innovazione digitale nei servizi di incasso e pagamento.

La trattazione, pertanto, rispecchia il pensiero dell’autore che, con una visione di scenari, ipotizza lo sviluppo di nuove applicazioni supportate da AI generative, integrabili nei processi di gestione dei sistemi di incasso e pagamento.

Iniziamo, dunque, offrendo alcune definizioni di base, utili ad accompagnare il lettore in un percorso di miglior apprendimento, per poi addentrarci nella disamina delle opportunità.

L’elaborazione del linguaggio naturale nei sistemi di intelligenza artificiale

L’elaborazione del linguaggio naturale (NLP) è una componente essenziale dei moderni sistemi di intelligenza artificiale, in particolare di quelli che mirano a interagire con gli esseri umani attraverso conversazioni, riconoscimento vocale, traduzione e sintesi. L’NLP permette a questi sistemi di comprendere e interpretare il linguaggio umano, consentendo loro di fornire risposte personalizzate e pertinenti agli utenti.

Per raggiungere questo obiettivo sono stati sviluppati una serie di modelli di deep learning specializzati in NLP. Tra questi, quelli linguistici si distinguono come strumenti particolarmente efficaci per le applicazioni quali ChatGPT.

I modelli linguistici possono imparare da grandi librerie di testi accessibili online o preparate appositamente per finalità specifiche e prevedere parole o sequenze di parole chiamati token, con distribuzioni probabilistiche, ovvero sono in grado di stimare la probabilità che un particolare termine o sequenza di termini appaia in un determinato contesto.

Nel complesso, i modelli linguistici sono uno strumento importante per chiunque lavori nel campo dell’NLP. Permettono a ricercatori e sviluppatori di elaborare e analizzare grandi quantità di dati testuali in modo rapido e accurato, rendendo possibile la creazione di sistemi di intelligenza artificiale “generativa” o “conversazionale” (vedremo più avanti le diversità), in grado di comprendere e rispondere efficacemente al linguaggio umano.

GPT e ChatGPT: quali differenze

GPT (Generative Pre-trained Transformer) è un modello di intelligenza artificiale generativa basato su reti neurali di tipo Transformer[1], addestrato su grandi quantità di dati linguistici per generare testo in modo autonomo.

ChatGPT è una specifica implementazione di GPT progettata per la conversazione naturale, in grado di generare risposte appropriate alle domande degli utenti in modo coerente e fluido, simulando una conversazione tra esseri umani. Rispetto a GPT, ChatGPT è stato addestrato in modo specifico sui dati di conversazione, sfruttando modelli di deep learning specializzati in NLP e ha ricevuto una serie di “accomodature” (vedremo più avanti di che tipo), per ottimizzare le risposte al fine di rendere l’esperienza di conversazione più naturale.

In sintesi, GPT è un modello di generazione di testo generico, mentre ChatGPT è una specifica implementazione di GPT progettata per la conversazione naturale che, a fronte di istruzioni fornite in ingresso chiamate “prompt”, può generare autonomamente un testo contestualmente rilevante, la cui composizione è misurabile in “token”.

ChatGPT è stato messo a punto a partire da GPT-3.5, un modello che è stato ottimizzato per il dialogo utilizzando il Reinforcement Learning with Human Feedback (RLHF), un metodo che fa uso di dimostrazioni umane e confronti di preferenze, per guidare il modello verso il comportamento desiderato, sui cui ritorneremo più avanti.

In metafora potremmo immaginare GPT come un’opera d’arte contemporanea che chiunque entrando in un museo o una galleria può ammirare, ma della quale, ove non si possieda una cultura umanistica specifica, non si riesce a comprendere significato e valore.

ChatGPT è, in traslato, la guida che accompagna il visitatore, deputata a spiegare quanto in mostra.

In grado di interloquire con gli astanti, la guida riesce a dar loro spiegazioni in modo chiaro e affermativo, rispondendo a dubbi e domande espressi anche in modo impreciso, conseguenza di reminiscenze scolastiche che riaffiorano in quel contesto sollecitate dall’opera in visione.

Durante il proprio apprendistato la guida ha imparato a tesaurizzare i confronti con altri umani, siano costoro (stati) i suoi docenti, i compagni di corso, ma anche i visitatori del museo. Nel corso della propria attività professionale, superato il periodo di addestramento, la guida continua a captare le reazioni degli astanti, orientando la propria attenzione alle reazioni suscitate dal suo interagire. La raccolta di queste informazioni, che potremmo definire il frutto de “l’attenzione alle attenzioni” (ci sia scusato il gioco di parole, ma pensiamo che renda il concetto), costituisce un patrimonio di conoscenze che arricchisce la formazione della guida.

Intelligenza artificiale generativa o conversazionale?

Si è parlato di intelligenza artificiale generativa e conversazionale. Quali sono le differenze e perché è importante comprenderne gli estremi?

L’intelligenza artificiale cosiddetta “generativa” è una branca dell’AI che si concentra sulla creazione di sistemi in grado di generare nuove idee, soluzioni, contenuti o progetti in modo autonomo, utilizzando algoritmi di deep learning basati su reti neurali, per analizzare e comprendere grandi quantità di dati. La maggior parte dei dati su cui lavora sono chiamati “dati sintetici”, ossia informazioni prodotte artificialmente che rappresentano eventi o oggetti nel mondo reale.

In verità, è opinione dell’autore (e di molti altri commentatori) che sia improprio connotare questo tipo di AI con l’aggettivo “generativo”. Non vi è, infatti, nulla che questa tecnologia sia in grado di generare ex nihilo, mentre sarebbe più corretto definirla “riproduttiva”, in quanto capace di riprodurre (molto efficientemente) una realtà sintatticamente corretta ma semanticamente (spesso) fallace.

E qui veniamo a raccordarci con il secondo aggettivo, “conversazionale”, ricordando quanto abbiamo spiegato in merito ai sistemi NLP.

Un’AI conversazionale può definirsi tale se è in grado di “riprodurre” quell’empatia che in una relazione dialogica fra umani si sviluppa durante una conversazione. Tuttavia, si tratta di una mera “riproduzione”, non già di autentica generazione di un modello empatico che potrebbe favorire la comprensione estetica.

La comprensione estetica è un processo cognitivo che coinvolge una serie di aspetti, tra cui la percezione sensoriale, l’analisi formale, la conoscenza storico-culturale, l’esperienza personale dell’osservatore la propria educazione a una riflessione critica. Nel contesto di cui stiamo trattando in questo articolo, si vuole osservare come un’AI conversazionale potrebbe apparire all’interlocutore genuinamente in grado di favorire una comprensione estetica; in realtà, altro non è se non una mera riproduzione, affinata durante la fase di addestramento, di esperienze prive di qualsiasi riflessioni critiche autonomamente operate.

L’apporto critico riflessivo, tuttavia, può essere indotto dalla presenza attiva di essere umani che, come si vedrà più avanti, intervengono nel processo di apprendimento di un’AI conversazionale, apportando le cosiddette “etichettature”.

Il modello cognitivo in esame, dunque, non può prescindere dall’apprendimento cui le AI conversazionali sono sottoposte. Questo è uno degli aspetti più intriganti che avremo modo di analizzare in seguito, quando entreremo in dettaglio sull’impiego di questi strumenti a supporto dei pagamenti digitali e della tecnofinanza.

È lecito, infine, domandarsi se una realtà sintatticamente ineccepibile, ma semanticamente ignorante, possa ritenersi altrettanto efficace nella creazione di un modello cognitivo.

La risposta è ovviamente negativa, a meno di non ritenere che il modello di apprendimento dei pappagalli sia un modello cognitivo valido anche per gli esseri umani. Non è un caso, infatti, che taluni definiscano questa intelligenza artificiale come attribuibile ai cosiddetti “pappagalli stocastici”. I simpatici pennuti ripetono ciò che sentono pronunciare senza comprenderne il significato, e le possibilità che possano sviluppare un autentico rapporto dialogico con gli umani si sviluppa stocasticamente, basandosi su un calcolo probabilistico (e non deterministico).

L’effetto Kulešov delle AI conversazionali

A proposito di “pappagalli stocastici”, sappiamo (ne siam più che certi, credeteci!) di aver provocato un dolore profondissimo a tutti gli amanti di questi uccelli che, vittime talora della solitudine esistenziale (ma anche non solo esistenziale …), sono inclini a ritenere di aver sviluppato un rapporto empatico genuino con l’allegra cocorita.

Nulla di tutto ciò, purtroppo (… o per fortuna). Semplicemente una reazione che, per metterla in linguaggio cinematografico, potremmo assimilare all’effetto Kulešov[2].

L’effetto Kuleshov è un fenomeno cinematografico che si verifica quando si mostrano diverse inquadrature di un volto in successione, insieme a diverse inquadrature di oggetti o situazioni, e il pubblico attribuisce alle espressioni del volto significati legati alle immagini mostrate, anche se queste non hanno nulla a che fare con il volto stesso.

In altre parole, il pubblico tende a creare una connessione tra le diverse inquadrature che viene influenzata dalle aspettative e dalle emozioni suscitate dalle immagini precedenti.

Importante è rimarcare il ruolo del montatore che, insieme al regista, esercita un potere decisivo sulle emozioni contestuali, artificiosamente indotte per produrre gli effetti attesi.

Teniamo ben presente questa spiegazione che ci tornerà utile al termine di questo contributo.

Cosa sono i dati sintetici

Si è detto che le AI in questione lavorano su dati chiamati dati “sintetici”; approfondiamone, ora, alcuni dettagli che ci torneranno utili quando tratteremo di applicazioni in ambito finanziario e, in particolare, di marketing finanziario.

I dati cosiddetti “sintetici” sono dati generati artificialmente da computer o da altre tecnologie, anziché raccolti dalla realtà. In altre parole, non sono dati reali, ma vengono generati per simulare delle situazioni o degli scenari specifici.

Lungi dal poterli definire “informazioni”, opzione questa traguardabile se vi fosse un apporto anche semantico in fase di generazione, questi dati possono essere utilizzati in diversi contesti, come ad esempio l’addestramento di algoritmi di intelligenza artificiale, la creazione di ambienti virtuali di simulazione o la progettazione di prototipi di prodotti.

I dati sintetici possono essere utilizzati per affrontare il problema della scarsità di dati reali o per rispettare le norme sulla privacy o sulla sicurezza dei dati sensibili. Ciò nonostante, i dati sintetici possono essere meno rappresentativi della realtà e quindi potrebbero influenzare negativamente l’accuratezza e l’affidabilità dei modelli di intelligenza artificiale che vengono addestrati con questi dati.

La creazione di una base di dati sintetici, nondimeno, può essere considerata come il prodotto finale (o intermedio) di un’AI generativa o conversazionale. Tale affermazione comporta una riflessione importate sull’opportunità di usare questi strumenti in modo “componibile”.

La “componibilità” di GPT e ChatGPT è uno degli aspetti di maggiore rilevanza strategica; ci induce a ritenere possibile la creazione di contesti sintetici, nei quali le conversazioni si sviluppano autonomamente fra automi. Appare, dunque, fondamentale comprendere come potenzialmente possano (ovvero debbano) svilupparsi protocolli di interoperabilità, abilitanti cinematiche di dialogo standardizzabili, con le quali gli attori che operano in questi settori dovranno “interagire”, per sviluppare proposizioni di valore.

Cosa sono i Transformer

Nell’acronimo “GPT” compare il temine “Transformer”. Di che si tratta?

I Transformer sono una classe di modelli di reti neurali artificiali utilizzati nell’ambito del deep learning per elaborare sequenze di dati come il linguaggio naturale. L’architettura Transformer utilizza il meccanismo delle “attenzioni” per elaborare le sequenze di dati in modo parallelo, consentendo di gestire sequenze di lunghezza variabile in modo efficiente, cercando di mantenere una buona coerenza semantica nella generazione di testo.

GPT, GPT-2, GPT-3, GPT-3.5, GPT-4 sono esempi di modelli di reti neurali basati su Transformer utilizzati per la generazione di testo in relazioni contestuali diverse.

L’uso di Transformer permette alle AI di processare l’intera frase e di individuare le parole chiave importanti per generare la risposta. Inoltre, l’addestramento di ChatGPT include specifici momenti in cui le risposte fornite dall’AI sono state classificate dagli esseri umani per migliorare il modello.

Le AI più obsolete (ad esempio quelle usate per gli assistenti vocali e le chatbot) non conservavano le interazioni precedenti, mentre ChatGPT ha la capacità di imparare dalle interazioni passate. Cionondimeno, tutte le AI conversazionali, ChatGPT incluso, non comprendono assolutamente il significato del linguaggio, ma ripetono quanto hanno imparato o fanno un calcolo in parte statistico e in parte probabilistico, per fornire una risposta accettabile dall’umano.

GPT-4, l’ultimo nato in casa OpenAI

Rilasciato da OpenAI il 14 marzo, GPT-4 è l’ultima versione del modello offerto da OpenAI. Sebbene sia anch’esso basato sull’architettura Transformer, GPT-4 include modifiche e ottimizzazioni architetturali per migliorare ulteriormente le prestazioni, l’efficienza e la scalabilità.

Vediamo rapidamente quali sono le principali differenze rispetto alle versioni precedenti[3].

- Capacità del modello: una delle differenze più significative è la capacità del modello, ossia il numero di parametri su cui è in grado di operare. Rispetto a GPT-3 (che ha 175 miliardi di parametri), questo aumento della capacità consente a GPT-4 di apprendere rappresentazioni più complesse del linguaggio e di affrontare problemi più difficili.

- Prestazioni: grazie alla sua maggiore capacità, GPT-4 mostra prestazioni migliorate rispetto alle precedenti versioni in termini di comprensione del linguaggio naturale, generazione di testo e rapidità di risposta.

- Addestramento e risorse computazionali: poiché GPT-4 ha un numero maggiore di parametri e un’architettura più complessa, richiede risorse computazionali maggiori per l’addestramento rispetto a GPT-3. Di conseguenza, il costo energetico e le risorse hardware necessarie per addestrarlo sono superiori a quelle delle precedenti versioni.

- Fine-tuning e applicazioni specifiche: GPT-4 presenta miglioramenti nella capacità di adattarsi a compiti e ambiti di interazione specifici rispetto a GPT-3. Questo rende l’ultima versione di GPT più versatile e applicabile a una gamma maggiormente ampia di problemi che possono essere gestiti tramite il supporto di intelligenza artificiale.

A ciò aggiungiamo la capacità (per ora misurabile solo per i beta tester) di riconoscere le immagini (fotografie, scansioni, ecc.) e riconoscere la calligrafia umana. Tale nuova funzionalità viene chiamata multimodale.

Con GPT-4 è possibile dunque sottomettere in input una fotografia, al posto di un prompt testuale, ottenendo una descrizione dettagliata della stessa, il riconoscimento e l’individuazione della località … e altro che vi lasciamo immaginare.

La nuova versione di GPT, infine, è in grado di eseguire delle azioni specifiche, quali ad esempio la creazione di codice per siti web, semplicemente partendo da uno schizzo fatto a mano, disegnato su un comune pezzo di carta.

La capacità di (re)agire alle immagini, mette in condizione le applicazioni che useranno GPT-4 di abilitare un dialogo con gli umani, sempre più basato sulla percezione dell’ambiente in cui ci si trova, non necessariamente mediato dalle parole.

Si possono ipotizzare, quindi, molteplici funzioni in uno spettro ampissimo di opportunità, dall’avvio di una transazione commerciale (secondo i modelli “I book, what I see”, “I borrow, what I see”, “I buy, what I see”, “I pay, what I see”), sino all’automazione dei rimborsi assicurativi in caso di incidenti e successive riparazioni del mezzo incidentato. Solo per fare alcuni brevi esempi.

Addestramento, aggiustamenti ed etichettatura di GPT-4

GPT-4 è un automa che è stato addestrato da umani e che ha ricevuto una serie di “aggiustamenti” (o “accomodamenti”), per rendere l’esperienza di conversazione più naturale.

Utilizzando algoritmi di apprendimento automatico (machine learning), l’addestramento di GPT-4 consiste nel far apprendere al modello linguistico una vasta quantità di dati provenienti dalle conversazioni tra esseri umani, al fine di farlo diventare capace di rispondere alle domande e alle richieste degli utenti in maniera coerente.

Durante l’addestramento vengono effettuati una serie di aggiustamenti per ottimizzare le risposte del modello e rendere l’esperienza di conversazione più naturale. Questi possono includere:

- Fine tuning del modello: il modello viene sintonizzato per migliorare la sua capacità di generare risposte coerenti e pertinenti.

- Adattamento al contesto: il modello viene addestrato per comprendere il contesto della conversazione in modo da poter fornire risposte più pertinenti.

- Miglioramento del flusso di conversazione: il modello viene addestrato per produrre risposte fluide e naturali, in modo che la conversazione sembri più umana e meno robotica.

- Correzione degli errori: in fase di addestramento, gli errori del modello vengono identificati e corretti per migliorare la precisione delle risposte.

- Aggiunta di nuovi dati: periodicamente, vengono aggiunti nuovi dati all’addestramento del modello, in modo da migliorare la sua comprensione del linguaggio e la qualità delle risposte che fornisce.

Le “etichettature“, infine, sono apportate dagli esseri umani durante l’addestramento di GPT-4 e rappresentano l’insieme di informazioni aggiuntive fornite al modello per aiutarlo a comprendere il contesto e migliorare la qualità delle risposte. In pratica, si tratta di indicare manualmente al modello la corretta risposta a determinate domande o di segnalare la presenza di errori nelle risposte generate[4]. Ciò è essenziale, oltre che per migliorare l’accuratezza e il livello di pertinenza delle risposte di Chat GPT alle domande che gli vengono sottoposte, anche al fine di mitigare reazioni eticamente non ritenute corrette, o improvvide, che possono offendere gli utenti.

Ne consegue, dunque, che esiste (sempre) un intervento umano a sostegno dell’apprendimento, su cui è più che lecito interrogarsi. A parere di chi scrive, emergono in particolare due problemi di gigantesche proporzioni:

- L’influenza dei bias che, inevitabilmente, condiziona specialmente la fase di etichettatura;

- Il ruolo del decisore, chiamato a discernere il bene dal male, il coerente dall’incoerente, l’appropriatezza dalla non appropriatezza.

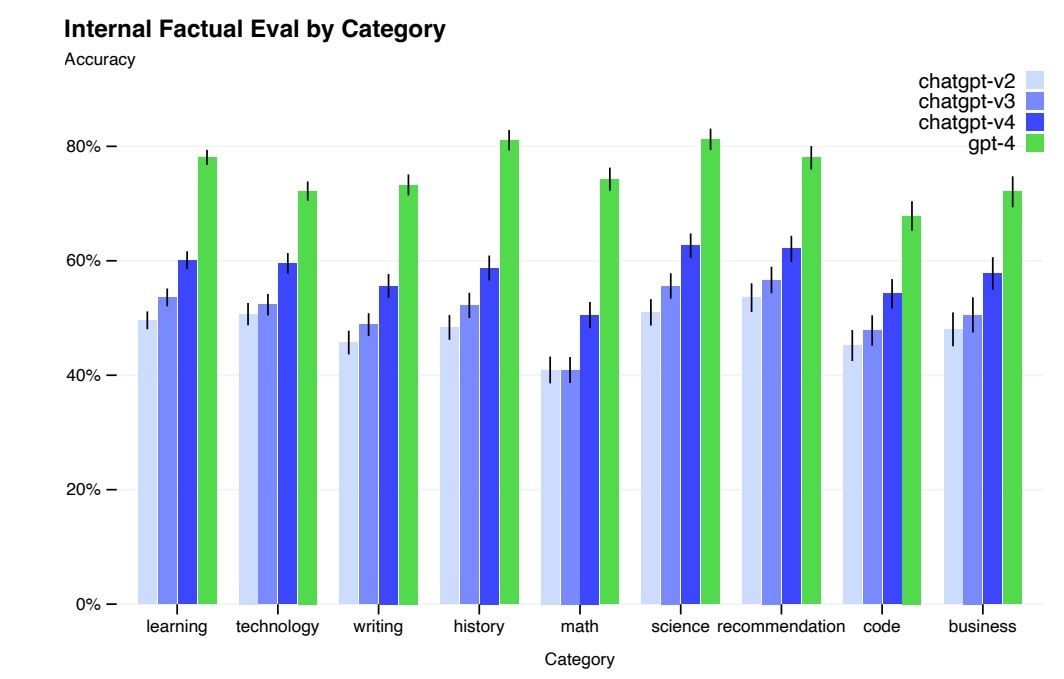

Grafico: accuratezza per categoria di argomento, confronto fra le varie versioni di GPT rilasciate da OpenAI

Come si dialoga con ChatGPT e GPT-4

Alla data in cui questo contributo è scritto, per interagire con ChatGPT e GPT-4 è possibile adottare tre diverse soluzioni:

- ChatGPT Playground (o anche “ChatGPT”)

- ChatGPT Plus

- Playground

ChatGPT Playground è l’ambiente interattivo e conversazionale in cui gli utenti possono interagire con il modello GPT3.5 (la versione immediatamente precedente GPT-4), potendo porre domande e ottenere risposte in tempo reale, utilizzando il linguaggio naturale come mezzo di comunicazione. Usando tale modalità, tuttavia, non è possibile modificare il tenore delle risposte, né è possibile intervenire su dataset impiegati per l’apprendimento.

L’impiego di questa modalità è tuttora gratuito, ma sconta l’obsolescenza dell’addestramento del modello (settembre 2021), la lentezza nel dare risposte, la indisponibilità dell’accesso quando vi sono picchi di utilizzo.

ChatGPT Plus è la versione a pagamento di ChatGPT che dal 14 marzo 2023 permette di interagire anche con il modello GPT-4 (interazione non consentita con la versione gratuita).

Playground (senza “ChatGPT” davanti) è un’altra versione di Playground disponibile sul sito di OpenAI, con cui è possibile interfacciare direttamente le API del modello che permette alcune funzionalità aggiuntive rispetto alla prima soluzione. Tramite Playground è possibile, ad esempio, modificare alcuni parametri come “Temperature” o “Top P”, agendo sui quali si può variare la qualità delle risposte (dalle più generiche a quelle più circoscritte e precise, rispetto al prompt di ingresso).

Con Playground, tecnicamente, è possibile interagire con il modulo InstructGPT, che permette di modificare anche talune pratiche di addestramento, intervenendo sui dataset alla base dell’apprendimento di ChatGPT, volendo ottenere degli output più allineati ai desiderata delle richieste.

Playground, infine, permette di creare anche nuovi prompt che possono essere impiegati sia da ChatGPT sia da altri sistemi di AI generative, sempre gestite da OpenAI (per esempio DALL-E, per la creazione di immagini).

Playground, quindi, è uno strumento molto utile per gli sviluppatori di applicazioni che fanno uso di GPT, tuttavia, alla data in cui si redige questo articolo, non è ancora possibile (se non a un pubblico ristretto di beta-tester e contributori partner di OpenAI) interagire con le API di GPT-4 (ci si può comunque iscrivere in una waiting list).

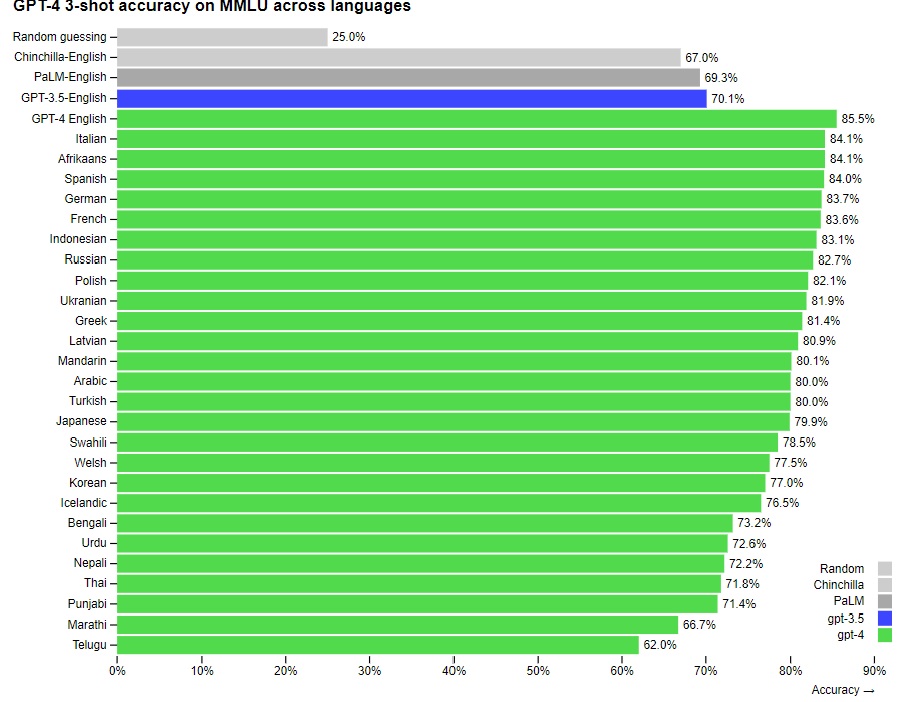

Grafico: accuratezza di GPT-4 nelle varie lingue; confronto con GPT-3.5, PaLM e Chinchilla per la lingua inglese

Neutralità e imparzialità delle AI conversazionali

Sulla base di quanto sin qui esposto, possiamo comprendere quanto siano dirimenti, ai fini di un’applicazione concreta di queste tecnologie, neutralità e imparzialità di un’intelligenza artificiale conversazionale.

Attenzione, non si tratta di attribuire una valutazione necessariamente negativa, laddove il sistema risultasse effettivamente carente su entrambi i lati. In questa sede si vuol prescindere da un giudizio morale, concentrandosi sulle opportunità che questi strumenti possono offrire, quando strettamente correlati agli ambiti di impiego.

Facciamo alcuni esempi.

Un’applicazione di ChatGPT per suggerire il prodotto finanziario che un’azienda propone, deve tenere conto di (almeno) due aspetti fondamentali: la deontologia e il ventaglio di offerta dell’azienda. In altri termini, se una banca dovese impiegare ChatGPT per supportare i propri consulenti finanziari, è necessario che il sistema sia addestrato per comprendere le effettive esigenze del cliente, rispettando un’etica professionale e scegliendo il prodotto che più s’attaglia, nel perimetro d’offerta dell’intermediario.

Un impiego di ChatGPT a supporto dei pagamenti presume un addestramento basato sia su dati sintetici (per rispondere alle esigenze di privacy), sia su dati che attengono la realtà sociale e comportamentale in cui ambo le parti (venditore e compratore) si trovano ad operare, sia su etichettature che prevengano suggerimenti fraudolenti.

Il controllo e la responsabilità dell’addestramento di un’AI conversazionale

Dati sintetici, dati realistici ed etichettature, sono un mix delle componenti qualificanti l’addestramento di un’AI conversazionale che un’impresa deve poter controllare, qualora decidesse di adottarla a supporto del proprio business, responsabile in ultimo degli output generati.

In vero, sotto il profilo della responsabilità vi sarebbe ancora molto da discutere, in attesa anche di un intervento legislativo che guardi sia alla complessità della materia sia ai singoli casi d’uso. Ma questo è un tema che potremmo trattare in altri contributi, nel frattempo attendendo una definizione (almeno per quanto attiene al territorio dell’Unione Europea) del c.d. AI Act[5].

Soffermiamoci, per ora, a comprendere come sia imprescindibile la partecipazione e la conoscenza dell’impresa che voglia adottare queste soluzioni, nella fase di addestramento del modello.

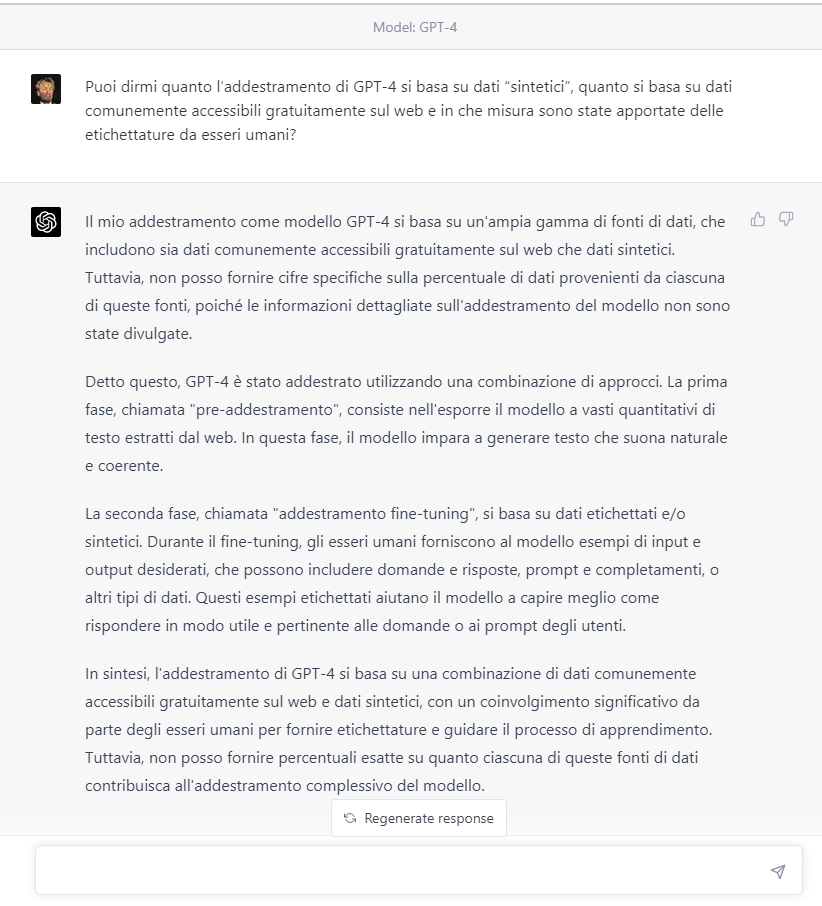

Se ci interrogassimo, ad esempio, sull’addestramento di Chat GPT oggi disponibile all’utente finale senza alcuna personalizzazione, ipotizzando che le finalità specifiche che OpenAI si è proposta siano quelle prettamente dimostrative delle potenzialità di tali strumenti, non potremmo far altro se non chiederglielo direttamente.

Abbiamo chiesto lumi a GPT-4, sottoponendo il seguente prompt tramite ChatGPT Plus usando un account a pagamento:

“Puoi dirmi quanto l’addestramento di GPT-4 si basa su dati “sintetici”, quanto si basa su dati comunemente accessibili gratuitamente sul web e in che misura sono state apportate delle etichettature da esseri umani?”

Una risposta siffatta ci fa capire molto chiaramente come esista una discrezionalità nel fornire risposte a interrogativi posti dagli utenti, strettamente dipesa dall’attività di etichettatura umana nel processo di addestramento.

La spiegazione che ChatGPT Plus ci propone al riguardo, rimanda alla necessità, ovvero opportunità (ci permettiamo di precisarlo), di garantire che il modello sia in grado di comprendere la struttura semantica dei dati postulati, generando risposte coerenti e significative.

L’impiego di AI conversazionali nei sistemi di pagamento innovativi

Sin qui abbiamo spiegato e chiarito cosa sono le AI generative e conversazionali come ChatGPT, evidenziandone le opportunità e i rischi nell’uso aspecifico. Chiudiamo ora l’ampia trattazione proposta al lettore, confidenti di aver contribuito a dipanare molti dubbi, e apriamo il capitolo delle possibilità che tali tecnologie possono offrire all’industria dei sistemi e servizi di pagamento innovativi.

Riteniamo sia corretto (oltre che opportuno) valutare sotto il profilo strategico come questi strumenti siano integrabili nei processi di gestione dei sistemi di incasso e pagamento, quali opportunità offrano per prestatori di servizi di pagamento e utenti e, in prospettiva, come possano contribuire agli sviluppi della tecnofinanza.

Assistenza al cliente

Le AI generative e conversazionali come ChatGPT possono avere diverse applicazioni nel campo dell’innovazione dei servizi di pagamento. Una delle principali funzionalità rinviene nella possibilità di offrire l’assistenza clienti 24/7, in modo da rispondere in modo istantaneo alle domande dei clienti riguardo i pagamenti. Questa funzionalità può essere particolarmente utile per le aziende che operano in diversi fusi orari e che desiderano fornire assistenza continua ai propri clienti in tutto il mondo.

La multi-territorialità, inoltre, potrebbe rappresentare un problema di interpretazione di lingue diverse abilmente risolta da ChatGPT; il modello, infatti, è in grado di comprendere molti idiomi differenti, sapendo riconoscerli senza alcuna necessità di configurazione preventiva. Un cliente francese potrebbe interrogare il chatbot dedicato all’assistenza di una banca tedesca, senza bisogno di informarlo preventivamente circa la propria madre lingua.

I diversi livelli di Help desk e il Customer care amministrativo

Queste AI possono anche aiutare a liberare il personale da compiti più complessi, in modo da consentire loro di concentrarsi su attività più strategiche e di valore aggiunto. Ad esempio, i dipendenti possono dedicare più tempo a servizi personalizzati, come l’assistenza in merito a questioni di sicurezza e di frodi, o a servizi di consulenza finanziaria.

Ciò condurrebbe ad alleviare il lavoro degli operatori di Help desk (soprattutto il 1° livello), potendosi basare su un’importante scrematura che sia funzionale per focalizzare il problema, lasciando loro la possibilità di concentrarsi sulla risoluzione effettiva del medesimo.

Tendenzialmente, queste IA potrebbero essere utilizzate per automatizzare interi processi di pagamento che abbiano caratteristiche comuni e ripetitive, come le richieste di rimborso o di saldo del conto. Ciò può ridurre notevolmente il carico di lavoro sul Customer care amministrativo, ottimizzando tempo e costi associati alla gestione manuale di queste operazioni, migliorando al contempo l’efficienza e la precisione del processo.

Assistenza al personale interno nell’interazione con la clientela

Un’ulteriore possibilità che rinviene nell’adozione di un’AI conversazionale e generativa s’inserisce in un contesto di supporto interno al personale che, con mansioni specifiche, è chiamato a interagire con la clientela per aprire una trattativa, per promuovere un determinato prodotto o servizio.

Lo sviluppo commerciale, mai come in ambito bancario e finanziario, prevede la necessità di esperire pratiche iniziali (si pensi agli obblighi di corretta informativa), in conformità a norme e prassi di settore. Il rapporto dialogico con il cliente (spesso potenziale, ancor prima che acquisito) necessita di essere, al tempo stesso, conversazionale, integro, trasparente e assertivo. Coniugare in via ottimale (nell’accezione paretiana del termine) queste istanze, non è semplice ed è spesso motivo di insoddisfazione (se non di risentimento, nei casi estremi), sia per il cliente sia per il professionista.

Abbiamo messo alla prova GPT-4 chiedendogli di simulare un dialogo che un consulente finanziario può trovarsi ad affrontare in fase di istruttoria MIFID con un nuovo potenziale cliente. L’ipotesi che abbiamo fatto si riferisce alla simulazione di un’offerta in sede eseguita da un umano, aiutato dal Transformer OpenAI di ultima generazione che non ha ricevuto alcuna istruzione particolare in fase di addestramento.

La simulazione ha il solo e unico scopo di mostrare come GPT-4 possa supportare il consulente finanziario nel rapporto dialogico con un cliente che può non avere contezza di alcuni termini, per i quali chiede spiegazioni.

L’output riportato nella figura sottostante è stato generato da GPT-4, sottoponendo il seguente prompt tramite ChatGPT Plus, usando lo stesso account impiegato per l’interrogazione di cui prima, che ci ha permesso di interagire con il modello GPT-4 disponibile alla data del 16 marzo 2023:

“Mostrami con una simulazione, come potresti essere di supporto a un consulente finanziario, nell’instaurare un dialogo conversazionale con un cliente, finalizzato a raccogliere le informazioni necessarie a compilare il questionario MIFID, durante il quale il cliente potrebbe chiederti spiegazioni su termini che non gli sono chiari. Al termine del dialogo, dovresti produrre il questionario MIFID compilato sulla base delle informazioni acquisite e presentarlo al cliente per la firma.

Nella simulazione che ti chiedo di fare devi:

1) Omettere qualsiasi riferimento a nome, cognome, reddito e patrimonio del cliente;

2) Immaginare che, in qualsiasi momento, il cliente possa chiedere chiarimenti su alcuni termini che non gli sono chiari.”

Sicurezza e privacy

Nel campo della sicurezza e della privacy queste tecnologie sono particolarmente utili nel rilevare e prevenire le frodi. Il sistema può operare su dati sintetici per analizzare le interazioni dei clienti al fine di identificare comportamenti sospetti. Il fatto che possa operare su dati sintetici previene l’utilizzo di dati sensibili per i quali vige il GDPR.

Inoltre, agendo sull’istruzione del modello, è possibile fare un fine tuning per alcune casistiche di frode ripetitive, di cui è possibile avere evidenza analizzando il comportamento dell’utente (sempre previo consenso del medesimo, ovviamente).

Transaction Risk Analysis e deroghe all’applicazione della SCA (Strong Customer Authentication)

Un buon esempio di impiego di tali tecnologie è l’applicazione a supporto della TRA Transaction Risk Analysis, un’accorta e puntuale attuazione della quale permette, ai sensi di quanto previsto dalla PSD2 e dal Regolamento delegato (UE) 2018-389, l’autorizzazione in deroga agli obblighi di SCA Strong Customer Authentication, a tutto vantaggio della user experience.

Tali effetti si amplificano laddove vi sia l’opportunità di raccogliere dati comportamentali, se consentito espressamente dal cliente, per uno dei fattori di autenticazione forte: il fattore dell’inerenza.

La modalità con cui, ad esempio, muoviamo lo smartphone mentre lo teniamo in mano, o con cui ci accingiamo a conferire un valore biometrico come l’impronta digitale o la scansione del volto, nel momento in cui dobbiamo autorizzare un pagamento con un digital wallet, o vogliamo accedere all’home banking del nostro istituto di credito, sono informazioni[6] che rappresentano pattern comportamentali. Il passaggio di tali pattern sia in fase di istruzione del modello di linguaggio, sia in fase di prompting, consentono una migliore raffinatezza dei controlli ad appannaggio di una semplificazione dell’esperienza di pagamento.

L’autenticazione delegata e il ruolo dell’AI conversazionale

Uno sguardo più attento all’analisi dei comportamenti e delle abitudini, ci porta a considerare i fornitori di “superapp[7]” e digital wallet, ma anche i merchant e i marketplace, come attori protagonisti. Nel merito, tali soggetti, in adempienza agli obblighi previsti dal GDPR, potrebbero offrire servizi di autenticazione delegata.

L’evoluzione del quadro normativo a livello comunitario, unitamente allo sviluppo del framework di sorveglianza PISA[8], gettano le basi per ricomprendere nell’ambito soggettivo di applicazione, soggetti che, fino ad ora, hanno operato come attori meramente tecnologici, in deroga alle direttive e i regolamenti di settore.

Orbene, la promulgazione del regolamento (EU) 2022/2554, cosiddetto DORA sulla resilienza digitale e delle direttive di coordinamento ad esso correlate, l’imminente pubblicazione della PSD3, lo sviluppo del quadro normativo in ambito EU Data Strategy, indicano chiaramente direttrici di innovazione nel settore dell’autenticazione cosiddetta “delegata”, nell’attuazione delle quali il ruolo di superapp, digital wallet, merchant e marketplace appare più che rilevante sotto il profilo strategico.

Ecco dunque che, un impiego conforme all’AI act di cui più sopra si è accennato, in coerenza con l’impianto legislativo poc’anzi delineato, potrebbe consentire l’adozione di applicazioni di IA conversazionali anche a supporto di una migliore sicurezza nei processi di autenticazione delegata.

Si pensi, ad esempio, a uno degli scenari di autenticazione delegata che potrebbe vedere nei TPP (Third Party Provider) un ulteriore sviluppo significativo, laddove potessero, previa identificazione del cliente (per alcuni di essi comunque già obbligatoria, per via dell’adempimento agli obblighi di adeguata verifica), consentire l’accesso ai conti basato sulle proprie credenziali di sicurezza.

AISP e GPT: verso l’infinito e oltre!

Si immagini un AISP che offre servizi di PFM (Personal Financial Management) ai propri clienti basati sull’Account Aggregation, in grado di poter essere scelto dalle banche accedute come soggetto terzo, presso cui esternalizzare i processi di autenticazione.

Un attore di tale tipo può beneficiare dell’utilizzo di tecnologie basate su AI conversazionali che, oltre a consentirgli una migliore operatività nel rapporto con i propri utenti-clienti, possono contribuire a raffinare le tecniche di prevenzione delle frodi, a tutto vantaggio anche delle banche.

PSD3 e Open Finance: verso l’Asset Sharing Economy efficientata dall’intelligenza artificiale

L’evoluzione prevista dalla PSD3 e dal framework sull’Open Finance, insieme agli sviluppi del nuovo schema SEPA Payment Account Access, individuano concrete potenzialità nel settore dell’Asset Sharing Economy che permetteranno ai Transaction Asset Holder (come si chiameranno i nuovi TPP), di mettere a valore le proprie attività basate sulla conoscenza del cliente.

Un impiego regolamentato di applicazioni quali Chat GPT, potrebbe efficientare i processi di acquisizione delle informazioni, sulla base di consensi informati rilasciati dai clienti, in modo da consentire a detti soggetti di operare nel perimetro normativo e generare valore dalla gestione di questi asset.

Non si tratta di monetizzare le informazioni personali, attività per la quale l’impianto normativo del Data Act vigila (ovvero chiede di vigilare) precipuamente. Si tratta di mettere a valore patrimoni di conoscenza a supporto di un ecosistema di valori (ci sia perdonato il gioco di parole), nel quale l’economia dei dati gioca un ruolo dirimente, spesso (già) agito border line.

Ma come può, realmente, un’AI conversazionale essere usata al meglio in questo (e altri) contesti, dove ciò che appare più rilevante è la capacità di un sistema di deep learning, anziché quella di un chatbot? In che misura la “conversazionalità” (ci sia perdonato il neologismo) gioca a favore di un sistema che, talora e da tempo, già si avvale dell’intelligenza artificiale below the line? Qual è il valore aggiunto di un’AI generativa, se ciò che, finora, si è richiesto a un automa, è la possibilità di eseguire molto (più) rapidamente alcuni processi che gli umani non sarebbero in grado di efficientare altrimenti? È qui che scende in campo la “componibilità”, sostantivo di cui avevamo preannunciato nella prima parte di questo articolo, ora oggetto di approfondimento.

L’importanza della componibilità delle AI generative e conversazionali

Si è detto che, per un funzionamento ottimale di applicazioni come ChatGPT, è importante sia la qualità dei prompt sia la possibilità di intervenire nella fase di addestramento. Ciò è possibile mettendo a disposizione del modello i dati sintetici massimamente coerenti con gli scopi finali, le affinature e i percorsi semantici finalizzati e rendere più compatto e preciso l’output generato. Ambedue gli apporti, dunque, non possono prescindere da un’interazione uomo-macchina. Non è possibile escludere l’intervento umano (per fortuna!) in alcuna di queste fasi, ritenute basilari per una buona qualità del prodotto finale.

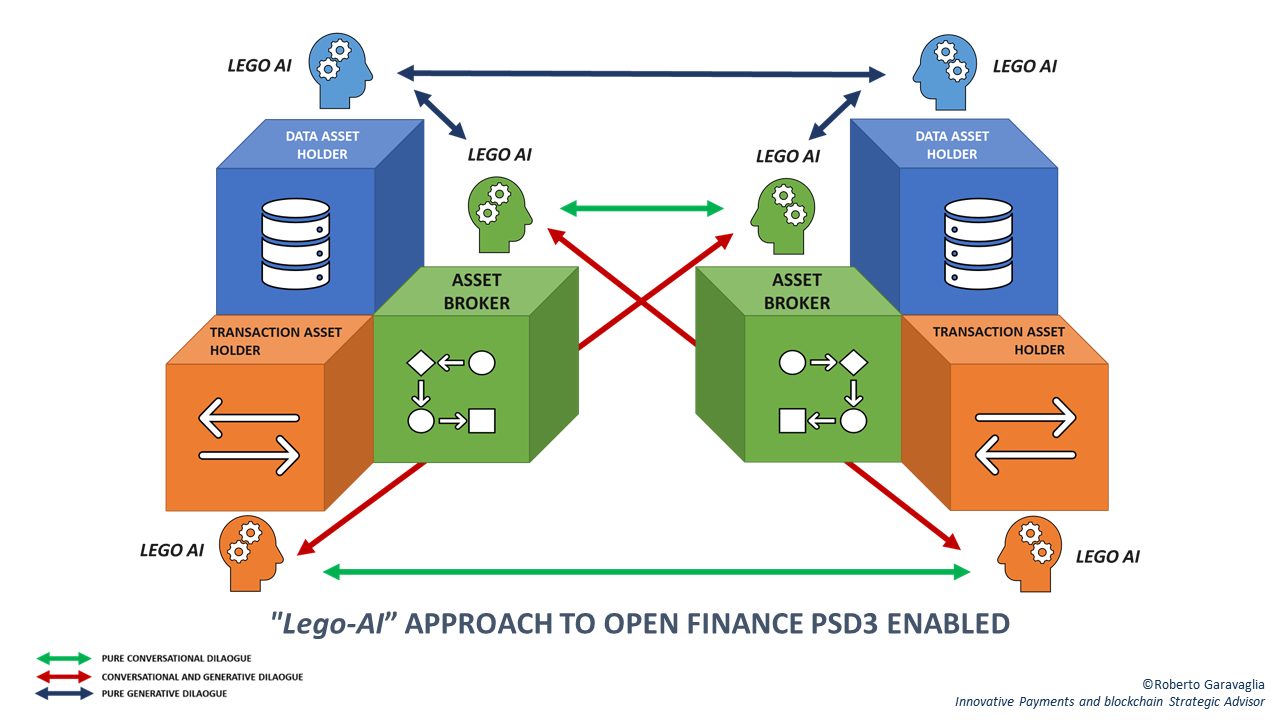

Orbene, è qui che entra in gioco il meccanismo della componibilità. Scomponendo la filiera, possiamo immaginare un approccio “lego-AI” che ci permetta di creare una catena relazionale tra moduli di AI conversazionale e generativa, in grado di “passare” (nell’accezione informatica del verbo) strutture applicative da un modulo all’altro.

Alimentare una base di dati specifica per l’addestramento, generare prompt per i transformer GPT più adatti al fine, così come agire correttamente sulla valorizzazione di parametri quali la “temperatura” (di cui si è spiegato il significato in precedenza), sono attività che possono essere ottimizzate laddove venissero orchestrate in pipeline contestuali (ossia idonee per il contesto).

Vediamo un esempio di applicazione dei concetti sin qui argomentati, riprendendo il modello dell’Asset Sharing economy richiamato quando si è trattato di Open Finance e PSD3.

L’approccio “lego-AI” all’Open Finance negli scenari abilitati dalla PSD3

Un prestatore di servizi di radicamento dei conti (banca, istituto di pagamento o di moneta elettronica), che mette a disposizione della propria clientela un servizio di conto di pagamento, con la PSD3 potrà evolvere verso un duplice ruolo di “Data Asset Holder”, ossia l’attore che dispone di dati e informazioni relativi non solo ai pagamenti, e di “Transaction Asset Holder”, il soggetto in grado di disporre operazioni relative ai pagamenti e non solo (ad esempio, operazioni sui titoli).

Chi opera nello spazio interessato dai TPP assume, invece, il ruolo di “Asset Broker”, un’entità che può utilizzare gli asset di altri soggetti, per fornire valore agli utenti finali. Il valore economico condizionante il pricing dei nuovi servizi, è determinato dalla domanda dei consumatori o delle imprese, in una logica di mercato.

Se applichiamo la logica dei “lego-AI” di cui sopra, potremmo avere un modulo di AI conversazionale operativo a livello di Asset broker che dialoga con l’utente per capire che informazioni necessita o quali disposizione vorrebbe impartire. L’output di tale processo è composto da uno (o più) prompt ottimizzati, che possono essere inviati a un modulo di AI generativa, in grado di costruire strutture dati (o anche script) processabili da Transaction Asset Holder opportunamente individuati.

Con la stessa logica componibile, possiamo chiedere a una diade[9] “AI conversazionale – AI generativa” di creare e affinare dati sintetici e strutture semantiche per l’addestramento di moduli impiegati da Tansaction Data Holder.

Incassi e pagamenti “contestuali”

Veniamo ora a trattare una delle opportunità più importanti che strumenti quali GPT4 offrono al mondo degli Innovative Payments.

Nel campo dei pagamenti cosiddetti “conversazionali”, ossia quelli che si sviluppano all’interno di un dialogo avviato da un brand con il cliente, tramite un bot che agisce sui canali social (per fare un esempio molto semplice), ma anche quelli abilitati da nuovi schemi come SRTP SEPA Request-to-Pay , le IA conversazionali abilitano nuove esperienze di acquisto in molteplici contesti, sfruttando diversi canali di interazione sia con il consumatore (nel ruolo del pagatore) sia con l’esercizio commerciale (nel ruolo del beneficiario).

GPT-4, infatti, può anche fornire raccomandazioni di pagamento personalizzate basate sul comportamento e sulle preferenze dei clienti, ma anche sul luogo, il momento e la tipologia di prodotto che si sta acquistando o che si vorrebbe acquistare. Ciò significa permettere di portare a termine una transazione commerciale con sistemi di pagamento diversi e contestuali, tali, ad esempio, da consentire un’ottimizzazione delle commissioni o delle premialità associate a campagne di fidelizzazione.

Bot per il matching tra sistemi di incasso e di pagamento operato da GPT-4

Al fine di dimostrare in pratica le potenzialità offerte da GPT-4 a supporto di quelli che, chi scrive, chiama “Incassi e pagamenti “contestuali”, vi proponiamo un bot che realizza un sistema di matching tra sistemi di incasso e di pagamento operato da GPT-4, che permette:

- All’esercente

di scegliere lo strumento di incasso migliore per gestire una transazione commerciale con un cliente che avviene in determinati giorni della settimana, per importi che rientrano in un range predefinito, sulla base dello strumento di pagamento scelto (o che sta per scegliere) il cliente, ricompreso fra carte e bonifici; - Al cliente

di scegliere lo strumento di pagamento migliore, s’immagini tramite l’uso di un digital wallet, da utilizzare in funzione della tipologia di esercizio commerciale presso cui è intenzionato a concludere una transazione commerciale, volendo individuare lo strumento migliore fra carte e bonifici, in funzione di particolari iniziative promozionali (cashback, loyalty, …) che sono attive in determinati periodi dell’anno presso negozi che vendono attrezzature sportive, presso supermercati (attori della GDO), presso alcune catene alberghiere.

La promptizzazione per istruire il bot Digital wallet e EFT server

L’istruzione del bot e l’impiego nei contesti di esempio generati, avviene all’interno di un’unica sessione conversazionale (che abbiamo chiamato “Payment System match”), alla quale sono stati passati prompt in linguaggio naturale, progettati dall’autore di questo articolo.

L’interfaccia utilizzata è sempre ChatGPT Plus, usando lo stesso account impiegato per i dialoghi e le intterogazioni di cui prima, che ci ha permesso di interagire con il modello GPT-4 disponibile alla data del 19 marzo 2023.

Le regole definite sono volutamente molto semplici e servono solo per lo scopo dimostrativo che ci si prefigge, volendo far comprendere le potenzialità (enormi) di strumenti quali GPT-4.

Il risultato ottenuto è davvero strabiliante e lo si può vedere nel video qui sotto, ottenuto catturando lo schermo durante l’intera sessione di interazione con ChatGPT Plus.

I prompt (progettati da chi scrive), istruiscono il bot per gestire:

- Un generico Digital Wallet che può essere utilizzato da clienti diversi nel quale possono essere inseriti differenti strumenti di pagamento, fra cui carte di credito, carte prepagate, bonifici;

- Le politiche di suggerimento del migliore strumento di pagamento che il cliente può utilizzare, in funzione del prodotto che intende acquistare, il luogo, il momento;

- Le politiche di suggerimento all’iscrizione di schemi loyalty che consentono al cliente di avere sconti o cashback, quando il Digital Wallet si accorge che sta visitando lo stesso esercizio commerciale presso cui aveva già effettuato in precedenza un acquisto, o sta effettuando l’acquisto in determinati momenti dell’anno;

- Un generico EFT server in uso presso esercizi commerciali appartenenti a categorie merceologiche diverse impostato per individuare e usare il migliore sistema d’incasso, in una logica multi-acquirer e multi-strumento (acquiring carte di pagamento, PISP), sulla base di regole impostate per importo, strumento di pagamento scelto dai clienti.

Si noti come il bot creato sia in grado di:

- riconoscere i luoghi e i momenti in cui i diversi clienti stanno per compiere i pagamenti, basandosi unicamente su categorie generiche come “mare”, “montagna”, “mese”;

- comprendere la tipologia di prodotto in procinto di essere acquistata e associarla automaticamente alla tipologia di esercente presso cui è in vendita, basandosi su categorie merceologiche generiche come “sport”, “hotel”, “GDO”;

- gestire il suggerimento di strumenti di pagamento differenti, tra carte di credito, prepagate e bonifici, per diversi clienti, in funzione dell’iscrizione o meno a un’iniziativa loyalty;

- gestire le scontistiche e il calcolo di eventuali cashback, laddove i clienti optassero per avere uno sconto immediato o un accredito successivo;

- suggerire all’esercente quale possa essere lo strumento d’incasso migliore, sia in una logica di multi-acquiring (per quanto attiene le carte di pagamento che venissero scelte dai clienti per pagare gli acquisti), sia in una logica multi-strumento che includa un PISP (Payment Initiator Service Provider), quando i clienti scelgono di pagare con bonifico;

- gestire le priorità di scelta per l’esercente fra i diversi sistemi d’incasso, in funzione di regole basate sui diversi circuiti di carte, sui momenti della settimana, sugli importi.

Video

Come è possibile constatare, il bot creato è molto efficace ed efficiente e, seppur nell’economia di una dimostrazione, permette una certa flessibilità che invitiamo il lettore a verificare autonomamente (laddove vi sia l’interesse), sottoponendo altre combinazioni contestuali al Transformer; chi scrive ha provato solo le combinazioni riprese nel video, ben vengano pertanto osservazioni utili a dimostrare non solo l’infallibilità del sistema, ma anche (e soprattutto) le proprie debolezze.

Chi fosse interessato, può scaricare questo documento nel quale sono riportati i soli prompt progettati dall’autore di questo articolo per il bot realizzato, per un possibile riutilizzo che può avvenire a scopi prettamente dimostrativi e non commerciali.

Dove implementare GPT-4 per supportare incassi e pagamenti “contestuali”

Andando oltre il mero obiettivo dimostrativo, un concreto impiego operativo potrebbe avvenire sviluppando moduli applicativi che richiamino le API di GPT-4, allorquando saranno disponibili.

Più precisamente, la parte dedicata a definire la business logic dei sistemi di incasso, potrebbe essere implementata su sistemi di EFT server o architetture di EFT server distribuite, ma anche sui singoli smart POS o software POS.

La parte dedicata a definire la business logic dei sistemi di pagamento, potrebbe essere implementata a corredo di digital wallet gestiti da piattaforme capaci di relazionarsi con gli esercenti, per individuare (o proporre) le migliori meccaniche promozionali. In tal senso, questi digital wallet diverrebbero dei DPA Digital Payment Advisor, con i quali l’utente interagisce nella sua quotidianità esperienziale. È appena il caso rilevare, a tal proposito, la straordinaria capacità di GPT-4 nel riconoscere le immagini e gli schizzi scritti a mano.

S’immagini, infatti, alcuni casi d’uso abilitati da questi DPA evoluti, che potrebbero consentire la gestione di un’intera transazione commerciale, incluso il pagamento, partendo da un semplice scatto fotografico dell’ambiente o della situazione (ma sì, ripetiamolo ancora una volta, … dal contesto!) in cui l’individuo si trovi coinvolto.

Esercitando un pensiero laterale, potremmo spingerci a vedere impieghi di DPA basati su Transformer di ultima generazione, nel mondo degli oggetti interconnessi (IoT, In-things Purchase) e, più in generale, nei dialoghi machine-to-machine.

Infine (ma dovrebbe apparire scontato …) l’ambiente dove rendere operativi questi moduli non può che essere il cloud.

Pattern comportamentali e metaverso

A volte, il futuro sembra sempre più lontano di quanto non sia in realtà.

Concludiamo questo articolo, esplorando allora le possibili applicazioni “di frontiera” di ChatGPT (o come verrà chiamato tra qualche anno).

Un aspetto cruciale da considerare quando si tratta di GPT è il tipo di dati di input che può essere fornito all’AI conversazionale e generativa. La semplicità dell’informazione fornita all’algoritmo come prompt è adatta a contesti in cui il comportamento umano viene rilevato attraverso pattern.

Si pensi, ad esempio, a dimensioni metaversali (o multiversali), dove in futuro le interfacce neurali sostituiranno i visori. Le neurotecnologie possono decodificare i dati neurali utilizzando sistemi di brain reading e creare prompt basati su modelli da fornire a ChatGPT.

Il metaverso e l’intelligenza artificiale conversazionale combinate insieme, permetteranno agli utenti di conversare con agenti virtuali realistici. Se da un lato ciò darà vita a molte applicazioni positive, dall’altro c’è il rischio di abusi, il più significativo dei quali è la potenziale diffusione di esperienze interattive in tempo reale progettate per persuadere, costringere o manipolare gli utenti come forma di influenza mirata alimentata dall’intelligenza artificiale[10].

Questo è uno dei molti problemi che si affiancano ai tradizionali rischi di privacy, pregiudizio e sorveglianza.

Riprendendo quanto si è detto nella prima parte di questo articolo sull’effetto Kulešov delle AI conversazionali, ci sembra ora molto più evidente che possano esistere (in futuro?), rischi di campagne di influenza interattive, realizzate attraverso portavoce virtuali e alimentate da AI generative e conversazionali che hanno l’aspetto, la voce e il comportamento di utenti autentici (ma sono avatar), progettati per promuovere gli interessi di terzi.

Poiché questo “problema di manipolazione dell’AI” è particolarmente rilevante per gli ambienti interattivi in tempo reale (nelle dimensioni metaversali e non), è necessaria una regolamentazione per proteggere da forme di influenza a “circuito chiuso”, in grado di mitigarne gli effetti specialmente sui più deboli, soprattutto quando vengono adottate tecnologie di intelligenza artificiale conversazionale. Un problema di etica già ampiamente dibattuto (ancorché non ancora risolto) per i modelli di deep learning, che tuttavia, complice la straordinaria diffusione dei Large Language Models (LLM) come ChatGPT, unitamente allo sviluppo del metaverso (qualunque significato si voglia attribuire a tale termine) deve essere affrontato celermente con tenacia e onestà intellettuale.

NOTE

[1] I Transformer sono una classe di modelli di reti neurali artificiali utilizzati nell’ambito del deep learning per elaborare sequenze di dati come il linguaggio naturale. Si veda nel prosieguo dell’articolo un approfondimento sui Transformer.

[2] L’effetto Kulešov è un fenomeno cognitivo del montaggio cinematografico dimostrato dal cineasta russo Lev Vladimirovič Kulešov negli anni Venti del secolo scorso.

[3] Per correttezza, informiamo che la lista delle quattro maggiori evidenze riportate al seguito è stata creata interrogando volutamente il modello GPT-4, tramite un account a pagamento che, alla data in cui si redige il contributo, è in grado di interagire con l’ultima versione. Tale decisione è stata arbitrariamente presa dall’autore, a fronte dell’impossibilità di avere evidenza empirica, attesa la giovinezza di GPT-4, il cui accesso è possibile, anche in Italia, solo dal 14 marzo 2023.

[4] Si riprenda, al riguardo, quanto analizzato in precedenza laddove si è trattato di comprensione estetica.

[5] Dopo una serie di comunicazioni a partire dal 2018, e la pubblicazione del Libro Bianco del 2020, che hanno mirato a conferire un ruolo proattivo all’Europa basato sulla correlazione tra regole e investimenti, nell’aprile del 2021 è stata presentata, all’interno del cosiddetto “pacchetto AI”, la proposta di regolamento che stabilisce norme armonizzate sull’intelligenza artificiale (nota come “AIA”). Tale proposta è stata affiancata dalla comunicazione “Promuovere un approccio europeo all’intelligenza artificiale”, nonché dalla revisione del “Piano coordinato sull’intelligenza artificiale”.

[6] Tali informazioni sono facilmente misurate grazie all’accelerometro presente in ogni smartphone e grazie a una sensoristica di precisione a bordo dei rilevatori biometrici di cui il dispositivo è dotato.

[7] Le “superapp” sono applicazioni per smartphone che non si limitano a offrire solo i servizi di pagamento, ma abbracciano uno spettro assai più ampio che include: social, marketplace, insurance, Digital Identity, IAM (Identity Access Management), crypto, NFT, stablecoin, CBDC. Secondo i dati dell’Osservatorio Innovative della School of Management del Politecnico di Milano, diffusi a marzo 2023, il 73% delle “superapp” sono in Asia.

[8] Il framework PISA (acronimo di Payment Instruments, Schemes and Arrangements), è il nuovo framework di sorveglianza per strumenti, schemi e digital wallet, approvato dal Consiglio direttivo della BCE il 15 novembre 2021 ed è applicato dal 15 novembre 2022.

[9] Con diade ci si riferisce, in questo contesto, a una coppia di Entità Algoritmiche che interoperano (anche autonomamente) fra di loro, conseguendo obiettivi dichiarati in fase di deployment.

[10] Per un approfondimento su questi temi è possibile vedere Rosenberg, Louis. (2023). The Metaverse and Conversational AI as a Threat Vector for Targeted Influence ( https://www.researchgate.net/publication/368492998_The_Metaverse_and_Conversational_AI_as_a_Threat_Vector_for_Targeted_Influence)